"As redes sociotécnicas das quais os processos algorítmicos fazem parte precisam ser analisadas em sua heterogeneidade e complexidade, bem como em sua dinâmica, levando em conta a diversidade dos atores vigentes em cada caso e buscando fortalecer essa diversidade num sentido político que esteja atento aos efeitos de viés, de discriminação, de produção de desigualdades etc., sabendo que por vezes esses efeitos não podem ser antecipados nem evitados por um dado conjunto de normas", afirma Fernanda Bruno, professora da Universidade Federal do Rio de Janeiro (UFRJ).

Segundo ela, "por isso é muito importante que adotemos uma perspectiva fortemente tecnopolítica em relação a tais processos, hoje tão determinantes em nossa vida pessoal e coletiva, garantindo que eles possam ser mais abertos e permeáveis à participação e ao questionamento da sociedade e da pluralidade de atores que a constituem".

Em entrevista à DigiLabour, 25-10-2019, Fernanda Bruno fala sobre racionalidade algorítmica, racionalidade neoliberal, data commons e smart cities, capitalismo de vigilância, projetos de “resistência”, vigilância automatizada e trabalho humano.

Fernanda Bruno (Foto: Lavits)

Fernanda Bruno, professora da Universidade Federal do Rio de Janeiro (UFRJ), é uma das referências nos estudos de vigilância na América Latina – a partir de uma perspectiva tecnopolítica. É membro-fundadora da Rede Latino-Americana de Estudos em Vigilância, Tecnologia e Sociedade/LAVITS e coordenadora do MediaLab.UFRJ. É uma das organizadoras do livro Tecnopolíticas da Vigilância, autora de Máquinas de Ver, Modos de Ser e de artigos como esse e esse.

O que você entende por racionalidade algorítmica?

Tenho proposto chamar de racionalidade algorítmica um modelo de racionalidade onde os algoritmos ocupam um lugar central nos processos de conhecimento de uma certa realidade, bem como nos processos de tomada de decisão e de gestão dessa mesma realidade. Um modelo de racionalidade implica simultaneamente produzir conhecimento e intervir sobre um determinado contexto, problema, fenômeno ou realidade. Em nossa sociedade, especialmente em nossas experiências tecnologicamente mediadas, os processos algorítmicos vêm se tornando atores decisivos tanto na captura e análise de dados sobre uma série de setores de nossas vidas privadas e comuns, quanto na tomada de decisão automatizada em diferentes contextos (gestão urbana, políticas públicas, comunicação, trabalho, mercado financeiro, estratégias de marketing e publicidade, segurança etc.). Torna-se assim fundamental entendermos que tipo de racionalidade é essa que hoje governa uma série de aspectos de nossa vida em sociedade assim como de nossas vidas pessoais. Em meu atual projeto no CNPq, tento fazer uma breve genealogia dessa racionalidade, procurando entender em que momento e de que maneira, historicamente, passamos a achar que as máquinas seriam mais eficientes que os humanos não apenas na execução de certas tarefas, mas também na capacidade de processar e produzir informação, assim como de decidir de modo mais confiável. Os nossos ideais de objetividade têm uma íntima relação com a mecanização e a automação, especialmente a partir do século XIX. O triunfo do algoritmo como modelo de gestão e decisão racional está relacionado a um deslocamento epistemológico (que se consolida na segunda metade do século XX, mais especificamente no pós-segunda guerra e na guerra fria), que marca a passagem do modelo iluminista de razão fundamentado na reflexividade crítica para um modelo de racionalidade baseado em regras algorítmicas. Claro que essa passagem não se dá de forma completa e esses modelos, na realidade, se sobrepõem e convivem.

Contemporaneamente, tenho procurado entender como essa racionalidade vem se afirmando e ganhando terreno nos mais distintos setores, das grandes corporações de tecnologia e de internet, às políticas de segurança e vigilância, ao sistema jurídico e à medicina. São notáveis alguns elementos, recorrentes em parte dos discursos (tanto científicos quanto corporativos) que defendem a adoção massiva de procedimentos algoritmos seja em contextos tradicionalmente regidos por humanos (como a Justiça Penal), seja em contextos cuja escala e complexidade ultrapassam os limites de uma gestão ou inteligibilidade exclusivamente humanas, como as plataformas digitais e todos os serviços e que operam com megadados (big data). São eles: a promessa de maior velocidade, de maior precisão e/ou eficácia, e de maior objetividade e neutralidade tanto nos mecanismos de entendimento/conhecimento, quanto nos processos de tomada de decisão. Enquanto o ganho em velocidade é incontestável, o ganho em precisão/eficácia não é tão evidente e a suposição de maior objetividade/neutralidade é extremamente equivocada, como vêm mostrando inúmeras pesquisas e casos sobre a presença de vieses (de gênero; raça; classe) nos processos algorítmicos de tomada de decisão.

Um elemento pouco mencionado pelas instituições e corporações, mas sobre o qual tenho insistido há algum tempo (assim como outras autoras e autores) é a dimensão performativa da racionalidade algorítmica. O tipo de conhecimento gerado por processos algorítmicos está em muitos casos em ruptura com os modelos representacionais de conhecimento, cuja força epistêmica seria a capacidade de descrever ou compreender uma realidade ou fenômeno dado, mantendo-se o mais fiel possível a um referente qualquer. A força da racionalidade performativa dos algoritmos não está em descrever ou representar, mas sim em gerar efeitos e produzir realidades. Um exemplo banal são os sistemas de recomendação, hoje quase onipresentes em serviços, plataformas e aplicativos digitais (e que tendem a se fazer presentes em áreas de aconselhamento e assistência no campo da saúde, da justiça e da gestão pública de recursos). Um sistema de recomendação é tão mais eficaz quanto mais ele consegue influenciar ou desencadear uma determinada ação ou comportamento; e não tanto em saber realmente o que eu gostaria de ouvir, assistir, consumir ou fazer num dado momento. Por conta disso, a distância entre o laboratório (ou qualquer processo de testagem controlada de tecnologias, produtos, serviços) e o mundo se torna quase inexistente nesse tipo de racionalidade. Porque devo elaborar uma teoria sobre o mundo (ou sobre qualquer fenômeno) e testá-la em condições controladas, se posso testar diretamente sobre o mundo? A racionalidade algorítmica implica, portanto, a transformação do mundo num imenso laboratório. Num artigo que será publicado em breve na Revista Famecos, propomos o termo laboratório de plataforma para explorar essa questão. Nos últimos anos, temos sentido os efeitos disso e eles são preocupantes.

Em que medida a racionalidade algorítmica se relaciona à racionalidade neoliberal?

Eu diria que a relação é bastante estreita, por diferentes razões. Vou mencionar uma, para não me estender demais e para falar de uma dimensão que conheço um pouco mais. A ênfase do neoliberalismo sobre as escolhas individuais, a autogestão e a competição tornam a racionalidade algorítmica uma forte aliada na assistência à decisão em contextos de crescente incerteza, tais como os atuais mercados de trabalho, sistemas de saúde, cenários econômicos, processos urbanos, territórios marcados por violência e insegurança cotidianas. A frágil perspectiva de projetos e horizontes coletivos nesses contextos incita a uma busca por soluções e empreendimentos individuais para quem os algoritmos vendem-se como aliados nas tomadas de decisão tecnicamente assistidas. Para dar um exemplo concreto: estou passando um período como pesquisadora visitante no Departamento de Humanidades Digitais do King’s College, em Londres, e tenho dedicado especial atenção à crescente utilização de inteligência artificial e mecanismos algorítmicos na saúde. O discurso, em boa parte referendado pelo NHS, que é o sistema nacional de saúde do Reino Unido, referência histórica de política pública em saúde, é o de que a assistência algorítmica à saúde (através de aplicativos móveis digitais – apps – por exemplo) é um grande aliado num modelo de assistência centrado no usuário e voltado para o empoderamento deste nos cuidados com sua saúde seja física, seja mental. Além, claro, de diminuir expressivamente os custos da assistência, um aplicativo pode te ajudar a lembrar de tomar medicamentos, a monitorar sintomas, praticar exercícios e adotar hábitos benéficos, alertar quanto ao momento de procurar um médico ou um centro de saúde etc.. A afinidade desse modelo com a racionalidade neoliberal que entende a saúde como um capital a ser gerido sobretudo pelo indivíduo, é patente e, na minha perspectiva, assustadora.

Você está na programação de um evento que está discutindo data commons e urbanismo de plataforma, com uma palestra sobre a arquitetura da violência de Estado no Rio de Janeiro. Como pensar urbanismo de plataforma e data commons em cidades no contexto brasileiro?

Confesso que sou bastante cética quanto ao urbanismo de plataforma e à criação de políticas de dados efetivamente comuns nas cidades brasileiras. O Rio de Janeiro foi, nas últimas décadas, um laboratório curioso nesse sentido, especialmente na gestão “olímpica” do Eduardo Paes. Como é sabido, o projeto de transformar o Rio numa “smart city” alimentada por dados cidadãos durou o tempo da euforia com os grandes eventos, especialmente Copa do Mundo e Olimpíadas, que a cidade abrigou em 2014 e 2016 respectivamente. Uma série de iniciativas que tinham o Centro de Operações do Rio (COR) e o Porto Maravilha como carros-chefe foram descontinuadas pouco tempo após os Jogos Olímpicos e especialmente após a vitória do atual prefeito Marcelo Crivella. Tanto o COR quanto o Porto Maravilha investiram fortemente em “soluções” e ferramentas que utilizavam dados fornecidos (com maior ou menor conhecimento) pelos cidadãos, mas a grande maioria dos projetos acabou mostrando-se pouco conectada com as demandas da vida concreta na cidade, refletindo muito mais os interesses imediatos das corporações que participaram desse processo. Dois orientandos meus, na ocasião – Victor Vicente e Anna Berardi – dedicaram as suas dissertações de mestrado aos projetos de transformar o Rio numa smart city e foi impressionante perceber que ao fim das duas dissertações, ao cabo de apenas dois anos, esse projeto já pertencia ao passado e dele só restaram ruínas digitais e rastros com pouca relevância na atual dinâmica da cidade. Foi possível perceber como a relação com os dados da cidade e dos cidadãos pode ser extremamente predatória. Especialmente no caso do Porto Maravilha, foram instalados uma série de sensores e dispositivos que capturaram massivamente dados que depois simplesmente desapareceram. O COR teve uma trajetória diferente e de mais sucesso, com impactos efetivos sobre a cidade durante a gestão Paes, apesar de sempre ter estado muito aquém da promessa presente no discurso político e corporativo de então.

Hoje, o Rio de Janeiro está bastante distante de qualquer projeto de data commons e de urbanismo de plataforma, mas não para construir algo interessante. Muito pelo contrário, boa parte da tecnologia que o Estado e a cidade do Rio hoje implementam está atrelada a uma necropolítica feroz. Nesse evento que você menciona, vou apresentar um projeto que estou desenvolvendo em parceria com o Adriano Belisário (MediaLab.UFRJ e Escola de Dados) e o Paulo Tavares (UnB e agência Autônoma), onde usamos a metodologia da arquitetura forense para a produção de evidências sobre a violência do Estado sobre populações que vivem em favelas e comunidades. Nesse caso, temos o avesso de uma política de data commons. Temos, na verdade, uma espécie de blackout ou “apagão” de dados e nenhuma transparência sobre as operações do Estado nesses territórios. Assim, boa parte da nossa pesquisa (e de outras entidades e grupos que também vêm se dedicando a documentar e denunciar a violência de Estado), consiste em produzir e dar visibilidades a dados que em boa parte deveriam ser fornecidos pelo próprio Estado. Passamos de uma smart city “para inglês ver” a uma necropolítica que retoma seu padrão histórico de mirar contra a população pobre e negra da cidade.

Como você analisa a noção de “capitalismo de vigilância”, como compreendido pela Shoshana Zuboff, e de que maneiras distintas esse conceito aterrissa no Sul Global, considerando que a vigilância também é distribuída geopoliticamente?

A Shoshana realizou um trabalho admirável e de grande fôlego que conseguiu condensar e detalhar de forma muito astuta o que uma série de pesquisadores dos estudos de vigilância e da cultura digital já vinham tratando há algum tempo. A noção “capitalismo de vigilância” é especialmente feliz ao mostrar, em um só termo, como as engrenagens do capitalismo hoje são inseparáveis dos mecanismos de extração de valor dos dados que produzimos e fornecemos cotidianamente ao usarmos uma série de plataformas e aplicativos digitais. Apesar de achar que ela tende a uma visão excessivamente maniqueísta do poder, sinto-me muito próxima das análises sobre o caráter estratégico que as ferramentas de previsão e modulação de comportamento assumem no que ela chama de capitalismo de vigilância (e que eu prefiro chamar de capitalismo de dados pessoais). Quanto à recepção e presença dessa noção no Sul Global, creio que há muito a se pesquisar, mas percebo em geral uma acolhida entusiasmada por parte de pesquisadores e ativistas. Então, de imediato, eu diria que há um reconhecimento de que os processos descritos pela autora estão muito presentes entre nós e nos ajudam a avançar na reflexão e no debate sobre o assunto. Por outro lado, também percebemos que o capitalismo de vigilância tem peculiaridades e é ainda mais predatório ao Sul, seja pela frágil história de debate público sobre o tema, seja porque a nossa adesão às plataformas que alimentam hoje o capitalismo de vigilância global se dá num contexto de grande precariedade econômica e jurídica que tornam o uso dessas plataformas quase obrigatório para boa parte da população.

A rede LAVITS, da qual faço parte, tem produzido coisas interessantes sobre isso e destaco o trabalho do Rodrigo Firmino e do Bruno Cardoso sobre uma apropriação terrivelmente local do Uber, que retoma uma série assimetrias e explorações que fazem parte da história do trabalho doméstico no Brasil. Sabemos também que as apropriações locais podem se dar em direções mais libertadoras e inventivas, que rompem ou ao menos minimizam algumas das nossas assimetrias históricas. Acho fundamental inventariarmos e compartilharmos essas apropriações positivas, criando um repertório comum que, me parece, será cada vez mais importante.

Como você tem analisado projetos de “resistência” à vigilância mediada por algoritmos, tais como a Algorithmic Justice League e World White Web?

Esses projetos de “resistência” são fundamentais para criar ruídos, levantar problemas e promover algumas pausas (mesmo que breves) no ritmo frenético com que avança a vigilância mediada por algoritmos. Esses dois projetos que você menciona têm em comum a ênfase no viés racista e sexista dos algoritmos. Em âmbito global, essa ênfase no viés algorítmico tem sido recorrente e ela é importante por pelo menos duas razões: a primeira é a de colocar um dedo na ferida do discurso que proclama uma maior imparcialidade ou neutralidade nos processos e decisões mediados ou executados por algoritmos. Esses projetos, juntamente com uma série de outras pesquisas, têm mostrado que, ao contrário, os ambientes, plataformas, dispositivos e decisões automatizadas não são imunes aos vieses e assimetrias que estão presentes historicamente em nossas sociedades, em nossas práticas e em nosso juízo sobre o mundo e os outros. Mas há um agravante: o racismo, o machismo, as desigualdades de classe, gênero e raça são, de modo geral, encapsuladas, silenciadas e invisibilizadas nos sistemas algorítmicos, sob a equivocada perspectiva de que ali tais coisas não existem, uma vez que são as máquinas que estão no “comando”.

Essa é a segunda razão da importância desses projetos e pesquisas: eles abrem um pouco da caixa preta dos algoritmos e nos convocam a pensar e agir tecnopoliticamente, provocando as plataformas digitais e seus usuários a, pelo menos, levarem isso em conta. Ressalto aqui, os excelentes trabalhos de algumas pesquisadoras que vêm se dedicando a essa questão: Safiya Noble, Virginia Eubanks , Cathy O’Neil, Ruha Benjamin, Simone Browne. Não por acaso, os trabalhos mais interessantes sobre essa temática vêm sendo realizados por mulheres, sobretudo mulheres pretas, que finalmente levantaram o imenso e, contudo, silenciado problema das questões raciais e de gênero na cultura digital. No âmbito de coletivos, além desses que você menciona, lembro do trabalho do Tactical Tech e da ProPublica, que tem uma série bastante boa sobre viés algorítmico em sentenças criminais. No Brasil, destaco a Coding Rights e o marialab, bem como a Coalizão Direitos na Rede, que reúne diversos coletivos e entidades que atuam na defesa de direitos na cultura digital em geral.

Mas, para concluir esse ponto, eu gostaria de dizer que projetos como o Algorithmic Justice League e World White Web são super necessários e importantes, como eu disse, mas creio que temos que ir além da denúncia de viés. Temos que realmente pensar meios de compreender e questionar essa racionalidade algorítmica sob bases que não recaiam em dicotomias que não dão conta da complexidade do problema, e que costumam ver os processos algorítmicos seja como mero reflexo das intenções e preconceitos dos humanos ou das instituições que os programas, sejam como o espelho oculto de estruturas sociais.

As redes sociotécnicas das quais os processos algorítmicos fazem parte precisam ser analisadas em sua heterogeneidade e complexidade, bem como em sua dinâmica, levando em conta a diversidade dos atores vigentes em cada caso e buscando fortalecer essa diversidade num sentido político que esteja atento aos efeitos de viés, de discriminação, de produção de desigualdades etc., sabendo que por vezes esses efeitos não podem ser antecipados nem evitados por um dado conjunto de normas. Por isso é muito importante que adotemos uma perspectiva fortemente tecnopolítica em relação a tais processos, hoje tão determinantes em nossa vida pessoal e coletiva, garantindo que eles possam ser mais abertos e permeáveis à participação e ao questionamento da sociedade e da pluralidade de atores que a constituem. O presidente Jair Bolsonaro há pouco tomou uma decisão completamente equivocada, ao meu ver, vetando o direito (previsto na Lei Geral de Proteção de Dados Pessoais) de um usuário solicitar a revisão humana de uma decisão automatizada. Entende-se, com esse veto, que a racionalidade algorítmica (que, claro, não é atributo do algoritmo em si, mas de uma rede de corporações, protocolos, códigos, interesses econômicos etc.) deve ser impermeável à revisão e ao questionamento de grande parte da sociedade, o que é desastroso.

Grandes empresas de tecnologia, como Facebook e Amazon, admitiram nos últimos tempos terem contratado trabalhadores terceirizados para ouvir e transcrever áudios dos usuários. O quanto a “vigilância automatizada” (termo do Andrejevic) ainda tem de trabalho humano?

De um lado, há muito mais humanos do que se imagina no trabalho automatizado, atualizando velhas e produzindo novas desigualdades. O mesmo se passa com a vigilância automatizada e há muito a se pesquisar e a se discutir sobre isso, pois estamos claramente vivendo uma reconfiguração das condições e das relações de trabalho que vai se radicalizar com a expansão da inteligência artificial e da Internet das Coisas. Esse trabalho humano, nos casos que você menciona (e que não incluem apenas Facebook e Amazon, mas também Apple, Microsoft e Google) é em grande parte feito para treinar as máquinas e otimizar os algoritmos na função de reconhecimento automatizado de voz. Esse tipo de trabalho é enorme e o inquietante é que ele é feito para desaparecer. Ou seja, trabalhadores humanos treinam máquinas que em breve os tornarão dispensáveis. Não por acaso, esse trabalho é feito por pessoas que vivem em grande precariedade. Na mesma linha, há o trabalho humano voltado para complementar o trabalho automatizado, seja porque as máquinas ainda não dão conta de todo o serviço, seja para contornar alguma barreira legal ou financeira: é o caso das já conhecidas “Click Farms”(Fazendas de Cliques) e dos moderadores de conteúdo para as grandes corporações como Facebook, Twitter e Google (retratados no documentário The Cleaners). Esses trabalhos são insalubres e causam danos psíquicos e afetivos graves.

De outro lado, temos um cenário não menos complicado, que é a assistência maquínica ou algorítmica ao trabalho humano, institucional e corporativo e que pode não apenas representar uma redução dos postos de trabalho em domínios como a medicina, o direito e a prestação de serviços no campo de seguros, créditos etc., mas uma imensa desigualdade no acesso a serviços. Olhando para o modo como as coisas estão caminhando hoje, há um sério risco de que o acesso a serviços prestados por humanos seja reservado às elites ou a casos extremos, enquanto a população em geral, especialmente a mais pobre, será cada vez mais assistida por máquinas no campo da saúde, do direito, dos sistemas de crédito, de seguros etc. Isso já acontece nos bancos e em diversos serviços e tende a se estender para outras áreas consideradas vitais, como a medicina (retomando o exemplo que dei acima).

No livro Automating Inequality, Virginia Eubanks mostra como a automação de decisões no serviço público dos Estados Unidos tem produzido muito mais punição e policiamento dos pobres do que a efetiva assistência a que se propõe. A partir de três detalhados estudos de caso de serviços públicos de assistência social, moradia e proteção à criança, ela mostra como o uso de big data e de algoritmos para tomada de decisão vêm, na realidade, ampliando a desigualdade social. Sabemos ainda que os processos automatizados são extremamente fechados a negociações e contestações, tornando extremamente penoso para o usuário do serviço reverter a menor falha ou resolver o menor dos problemas. Há, portanto, muitos embates a travar para que a proclamada eficiência da automação nas políticas públicas seja efetiva e não torne o diálogo, a negociação, a contestação no acesso a serviços e direitos um privilégio das elites.

Acabei fugindo um pouco do tema central da questão, mas valeu para reforçar algo que apontei ao longo da nossa conversa e que retomo, adicionando uma perspectiva feminista para finalizar. É urgente retomarmos uma perspectiva tecnopolítica para esse mundo cada vez mais mediado por agentes maquínicos. Em oposição a uma racionalidade algorítmica que vem se mostrando predatória e irresponsável, vale propor uma tecnopolítica feminista – e aqui me inspiro fortemente em Donna Haraway – que insista na importância de construirmos conexões, composições, parentescos humano-maquínicos capazes de criar mundos comuns pelos quais possamos responder. Responder aqui remete em parte à responsabilidade, mas não no sentido liberal de ser o autor de suas próprias escolhas, no âmbito individual, mas no sentido de ser capaz de responder junto e com o outro – humanos e não humanos – pelo mundo que estamos criando. Responder também no sentido ético-político de cuidar e de se estar aberto a revisões de nossas próprias posições, pois tanto o conhecimento quanto a política implicam menos previsão e controle e mais relação e construção, o que requer outro tipo de cuidado ontológico, epistemológico e ético-político. Um cuidado das relações – como as que mantemos com algoritmos, com a inteligência artificial e outras tantas tecnologias – que exigem um trabalho contínuo e constante de reflexão e questionamento. Haraway e Barad usam, em seus trabalhos, a noção de “response-ability”. Podemos também brincar com o português e pensar essa habilidade em responder de modo coletivo e relacional como uma forma de “co-responder”, no sentido de responder junto pelas conexões humano-maquínicas que estamos construindo.

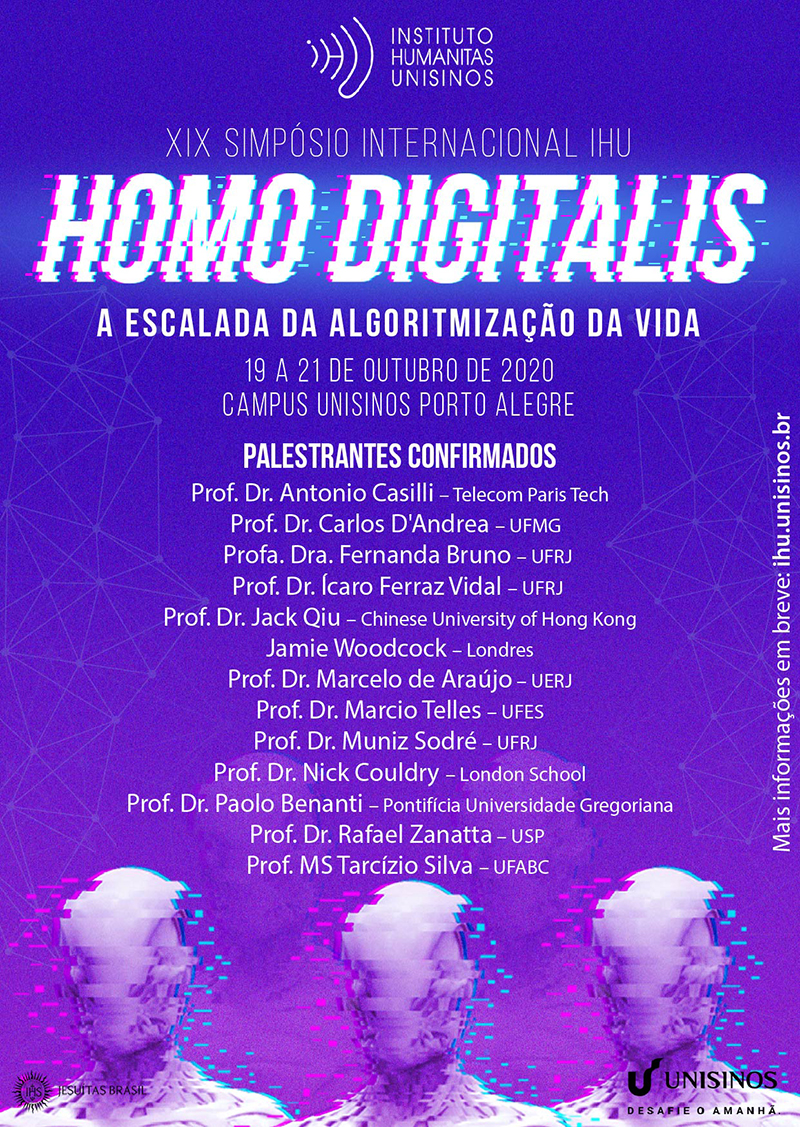

Nota da IHU On-Line: O Instituto Humanitas Unisinos – IHU promove o seu XIX Simpósio Internacional. Homo Digitalis. A escalada da algoritmização da vida, a ser realizado nos dias 19 a 21 de outubro de 2020, no Campus Unisinos Porto Alegre.

XIX Simpósio Internacional. Homo Digitalis. A escalada da algoritmização da vida.