O Google apresentou um sistema de inteligência artificial que transforma as descrições por escrito em imagens fotorrealistas. Porém, em um mundo cada vez mais dividido e em conflito, ele pode ser mais um instrumento capaz de se tornar uma arma muito poderosa para a verdadeira fronteira da guerra: a propaganda e a agressão psicológica.

A opinião é de Paolo Benanti, teólogo italiano e frei franciscano da Terceira Ordem Regular, professor da Pontifícia Universidade Gregoriana, em Roma, e acadêmico da Pontifícia Academia para a Vida.

O artigo foi publicado em seu blog pessoal, 25-05-2022. A tradução é de Moisés Sbardelotto.

O Google apresentou o Imagen (imagen.research.google), um sistema de inteligência artificial que transforma as descrições de palavras em imagens fotorrealistas. Diz-se que o gerador de imagens a partir de textos cria imagens mais realistas do que o DALL-E 2, da OpenAI. Ao contrário de seus concorrentes, porém, o Google não publicou esse modelo de inteligência artificial.

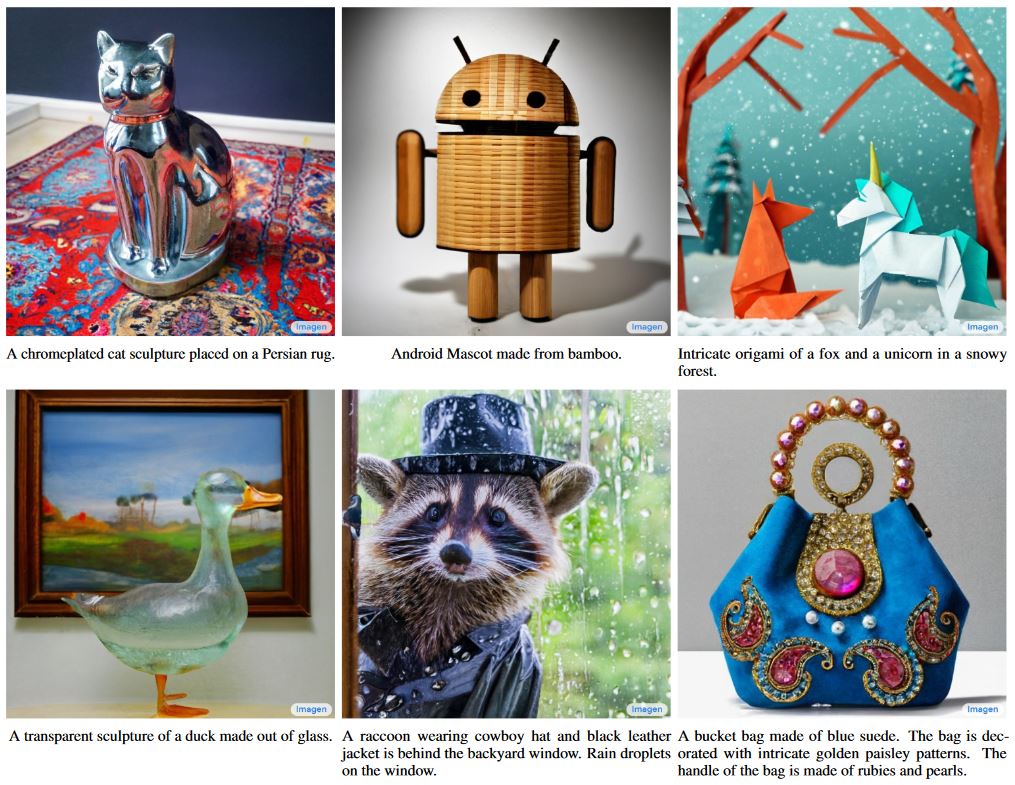

O modelo de difusão Imagen produz desenhos, pinturas a óleo, renderizações em CGI e muito mais (como as imagens aqui abaixo) com base em uma solicitação por escrito dos usuários. Os desenvolvedores do Imagen, o Brain Team do Google Research, declararam que alcançaram um fotorrealismo sem precedentes graças aos modelos de transformação e de difusão da imagem.

Imagens criadas a partir de texto pelo Imagen, do Google (Foto: Google)

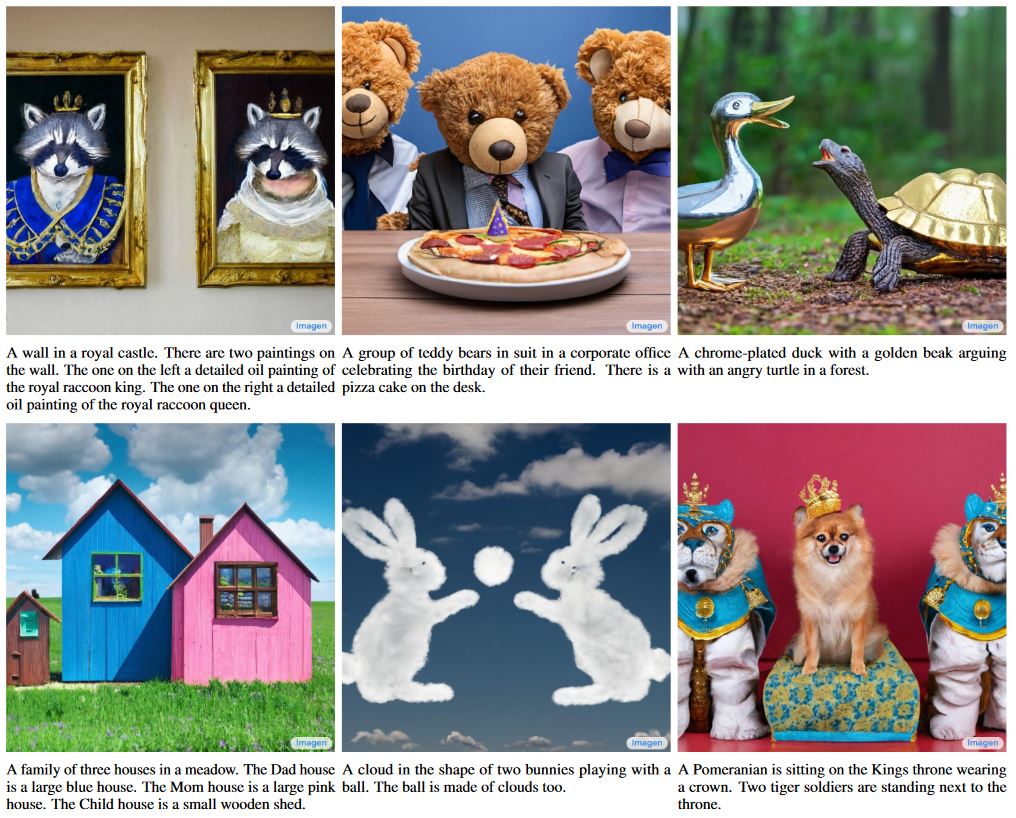

O Google afirma que os avaliadores humanos preferiram o Imagen a “todos os outros modelos” no que diz respeito à fidelidade da imagem e ao alinhamento entre imagem e texto. No entanto, o Google se apressou em especificar que o Imagen foi treinado com conjuntos de dados retirados da web e, portanto, pode refletir estereótipos e preconceitos prejudiciais.

Imagens criadas a partir de texto pelo Imagen, do Google (Foto: Google)

Uma coisa que vem à tona é que o modelo de Montain View, porém, obteve uma pontuação inferior na geração de rostos humanos do que outros elementos e que ele mostra uma tendência em relação às imagens de pessoas com a pele mais clara e retrata profissões que “se alinham aos estereótipos de gênero ocidentais”.

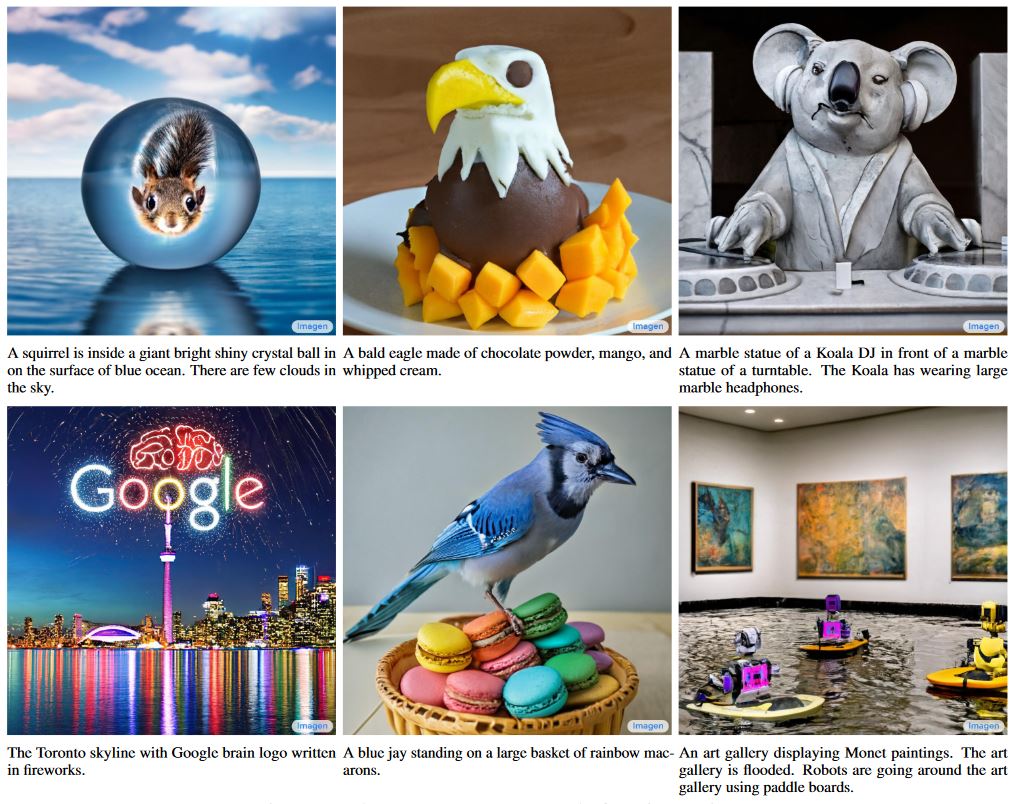

Imagens criadas a partir de texto pelo Imagen, do Google (Foto: Google)

A partir das notas do Google sabemos que, ao gerar imagens de eventos, objetos e atividades, o Imagen codifica “preconceitos sociais e culturais”. Por essas e outras razões, o Google não lançou o Imagen publicamente, embora permita que as pessoas o testem usando frases pré-selecionadas no site específico.

Não tendo outros elementos, relatamos o que está escrito no paper de apresentação [disponível em inglês aqui] do Imagen:

Apresentamos o Imagen, um modelo de difusão de texto para imagem com um grau de fotorrealismo sem precedentes e um profundo nível de entendimento da linguagem. O Imagen se baseia no poder dos grandes modelos Transformer de linguagem na compreensão de texto e se articula com a força dos modelos de difusão na geração de imagens de alta fidelidade. Nossa principal descoberta é que grandes modelos genéricos de linguagem (por exemplo, o T5), pré-treinados com corpora de texto somente, são surpreendentemente eficazes na codificação de texto para a síntese de imagem: aumentar o tamanho do modelo de linguagem no Imagen aumenta muito a fidelidade da amostra e o alinhamento imagem-texto muito mais do que aumentar o tamanho do modelo de difusão da imagem. O Imagen atinge uma nova pontuação FID no estado da arte de 7,27 no conjunto de dados COCO, sem nunca ter treinado no COCO, e os avaliadores humanos acham que as amostras do Imagen estão no mesmo nível dos dados COCO no alinhamento imagem-texto. Para avaliar os modelos de texto para imagem com maior profundidade, apresentamos o DrawBench, um benchmark abrangente e desafiador para modelos de texto para imagem. Com o DrawBench, comparamos o Imagen com métodos recentes, incluindo o VQ-GAN+CLIP, Latent Diffusion Models, GLIDE e DALL-E 2, e descobrimos que os avaliadores humanos preferem o Imagen a outros modelos em comparações lado a lado, tanto em termos de amostra qualidade quanto de alinhamento imagem-texto. [...]

Imagen mostra a eficácia de grandes modelos de linguagem fixada pré-treinados como codificadores de texto para a geração de texto para imagem usando modelos de difusão. Nossa observação de que dimensionar o tamanho desses modelos de linguagem tem um impacto significativamente maior do que dimensionar o tamanho da U-Net no desempenho geral incentiva futuros direcionamentos de pesquisa sobre a exploração de modelos de linguagem ainda maiores como codificadores de texto.

Além disso, através do Imagen, re-enfatizamos a importância da orientação sem classificador e introduzimos o limiar dinâmico, que permite o uso de pesos de orientação muito maiores do que os vistos em trabalhos anteriores. Com esses novos componentes, o Imagen produz amostras de 1024 × 1024 com um fotorrealismo sem precedentes e alinhamento com o texto.

Nosso principal objetivo com o Imagen é avançar na pesquisa sobre métodos generativos, usando a síntese de texto para imagem como um banco de testes. Embora as aplicações do usuário final de métodos generativos permaneçam em grande parte fora do escopo, reconhecemos que as possíveis aplicações a jusante desta pesquisa são variadas e podem impactar a sociedade de formas complexas. Por um lado, os modelos generativos têm um grande potencial para complementar, estender e aumentar a criatividade humana. Os modelos de geração de texto para imagem, em particular, têm o potencial de estender os recursos de edição de imagens e levar ao desenvolvimento de novas ferramentas para profissionais criativos. Por outro lado, os métodos generativos podem ser aproveitados para fins maliciosos, incluindo o assédio e a disseminação de desinformação, e levantam muitas preocupações em relação à exclusão e o preconceito sociais e culturais. Essas considerações moldam a nossa decisão de não liberar o código ou uma demonstração pública. Em trabalhos futuros, exploraremos um marco para a externalização responsável que equilibre o valor da auditoria externa com os riscos de um acesso aberto e irrestrito.

Outro desafio ético está relacionado aos requisitos de dados em grande escala dos modelos de texto para imagem, que levaram os pesquisadores a confiar fortemente em grandes conjuntos de dados extraídos da web, em sua maioria sem curadoria. Embora essa abordagem tenha permitido rápidos avanços algorítmicos nos últimos anos, conjuntos de dados dessa natureza foram criticados e contestados segundo várias dimensões éticas. Por exemplo, o discurso público e acadêmico sobre o uso apropriado de dados públicos levantou preocupações em relação à conscientização e ao consentimento do titular dos dados. As auditorias de conjuntos de dados revelaram que esses conjuntos de dados tendem a refletir estereótipos sociais, pontos de vista opressivos e associações depreciativas ou prejudiciais a grupos identitários marginalizados. O treinamento de modelos de texto para imagem com esses dados corre o risco de reproduzir essas associações e causar danos representativos significativos que impactariam desproporcionalmente indivíduos e comunidades que já sofrem marginalização, discriminação e exclusão na sociedade. Como tal, há uma infinidade de desafios de dados que devem ser enfrentados antes que modelos de texto para imagem como o Imagen possam ser integrados com segurança em aplicativos voltados para o usuário. Embora não abordemos diretamente esses desafios neste trabalho, uma conscientização das limitações dos nossos dados de treinamento orienta a nossa decisão de não liberar o Imagen para o uso público. Advertimos fortemente contra o uso de métodos de geração de texto para imagem para quaisquer ferramentas voltadas para o usuário sem um cuidado e uma atenção ao conteúdo do conjunto de dados de treinamento.

Os dados de treinamento do Imagen foram extraídos de vários conjuntos de dados pré-existentes de imagens e de textos alternativos. Um subconjunto desses dados foi filtrado para remover ruídos e conteúdo indesejável, como imagens pornográficas e linguagem tóxica. No entanto, uma recente auditoria de uma de nossas fontes de dados, LAION-400M, descobriu uma ampla gama de conteúdo impróprio, incluindo imagens pornográficas, insultos racistas e estereótipos sociais prejudiciais. Essa descoberta molda a nossa avaliação de que o Imagen não é adequado para o uso público neste momento e também demonstra o valor de auditorias rigorosas de conjuntos de dados e de documentação abrangente dos conjuntos de dados para moldar as decisões consequentes sobre o uso apropriado e seguro do modelo. O Imagen também se baseia em codificadores de texto treinados com dados em escala da Web sem curadoria e, portanto, herda os preconceitos sociais e as limitações dos grandes modelos de linguagem.

Embora deixemos uma análise empírica profunda dos preconceitos sociais e culturais codificados pelo Imagen para trabalhos futuros, nossas avaliações internas em pequena escala revelam várias limitações que orientam a nossa decisão de não liberar o Imagen neste momento. Primeiro, todos os modelos generativos, incluindo o Imagen, podem correr o risco de descartar modos de distribuição de dados, o que pode agravar ainda mais as consequências sociais do viés do conjunto de dados. Em segundo lugar, o Imagen apresenta sérias limitações ao gerar imagens que retratam pessoas. Nossas avaliações humanas constataram que o Imagen obtém taxas de preferência significativamente mais altas quando avaliadas sobre imagens que não retratam pessoas, indicando uma degradação na fidelidade da imagem. Por fim, nossa avaliação preliminar também sugere que o Imagen codifica vários preconceitos e estereótipos sociais, incluindo uma tendência geral de gerar imagens de pessoas com tons de pele mais claros e uma tendência de que imagens que retratam diferentes profissões se alinhem aos estereótipos de gênero ocidentais. Mesmo quando focamos gerações distantes das pessoas, nossa análise preliminar indica que o Imagen codifica uma série de vieses sociais e culturais ao gerar imagens de atividades, eventos e objetos.

Embora tenha havido um extenso trabalho de auditoria de modelos de rotulagem de imagem para texto e de imagem para formas de viés social, houve comparativamente menos trabalho sobre métodos de avaliação de viés social para modelos de texto para imagem, com a recente exceção de um trabalho. Acreditamos que este é um caminho crucial para pesquisas futuras e pretendemos explorar avaliações de referência para o viés social e cultural em trabalhos futuros – por exemplo, explorando se é possível generalizar a métrica de informação mútua pontual normalizada para a medição de vieses em modelos de geração de imagem. Há também uma grande necessidade de desenvolver um vocabulário conceitual sobre os possíveis danos dos modelos de texto para imagem que possam orientar o desenvolvimento de métricas de avaliação e moldar a liberação responsável do modelo. Nosso objetivo é enfrentar esses desafios em trabalhos futuros.

* * *

Assim como com o DALL-E, mais do que o espanto pela criatividade, o que me parece importante observar é a mensagem que o Imagen comunica: em um mundo invadido pelos dados, o poder é compreender o seu significado sem se perder.

O Imagen é uma máquina de significado, e, em um mundo cada vez mais dividido e em conflito, temo que esse seja mais um instrumento capaz de se tornar uma arma muito poderosa para aquela que hoje, como nos mostra a Ucrânia, é a verdadeira fronteira da guerra: a propaganda e a agressão psicológica.